究極のバイオハック、と言ってもいいかもしれません。

昨年秋に東京大学が行なったハッカソンJP HACKS。その中に他とはちょっと毛色が違ったデバイスがありました。

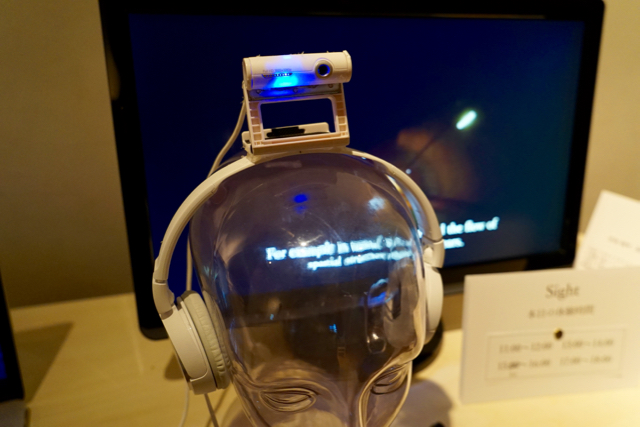

ヘッドフォンとカメラが一体になったデバイス「Sight」、テーマは「感覚の拡張」です。カメラで撮ってヘッドフォンで聞く…? まずは使用デモ動画をご覧ください。

トンネルを進んでいく映像。ランプが現れたり、出口が近づいたりと視覚を使って人間がとらえている景色の変化を音の変化として聞くことができるもの。色の違う積み木を音で聞き分けたり、手のグーとパーを当てたりということもできます。

赤と黄色、大小によって音が変わる

そして先日「Sight」は、経済産業省の未踏事業に採択され、本格的な開発に乗り出すことになりました。「世界が聴こえる」感覚拡張デバイスと、彼らの目指す人間の未来について話を聞きました。

*「未踏事業」は、優れたプロジェクトや開発者に対して経済産業省が開発を支援する事業。研究費などの援助を受け、9カ月間にわたり各分野のメンターの指導のもと研究開発を進める。インターフェース系の研究者の卵にとっては登竜門的な意味があるそうですよ。

***

「あの感じ」を聞く

ギズモード・ジャパン編集部(以下ギズ) まずは未踏事業への採択おめでとうございます。ハッカソンから始まった「Sight」ですが、どんなモチベーションで開発をはじめたんですか?

伏見遼平さん/専門はビジネス・ハードウェア、ハードウェア実装とディレクションを担当

伏見遼平さん(以下、伏見) こういうデバイス見るとまず思うのは「目が見えない人が見えるようになる」というようなことが多い。でも僕らはそうではなくて、共感覚や、イルカやコウモリのエコーロケーション(超音波を発信し反響を聞くことで空間を知覚)、あるいは視覚障がい者が壁に反響した足音や杖の音を聞くことで壁の近さや周りの環境を知る、こういった空間知覚がどういうものなのかを体験したかったんです。イルカになりたいとかコウモリになりたいとかが一番のモチベーション。

例えばSightを開発していた時期は秋だったんです。銀杏並木の道で銀杏の葉が降ってくる。積もった葉を踏んだときのさくさくした感じとか、まだ踏まれてないところのふわふわした感じ。これはどう考えても人の生活を支援することだけを目的として開発されたデバイスでは実現しえないものです。僕たちの視覚は生きていくため以上の情報を得ています。大学の講堂のアーチをくぐるとき、だんだん近づいていくと、自分の視覚のなかでアーチが大きくなっていく、そういう「あの感じ」みたいな感覚を音で体験できるようにならないかと。

ギズ 視覚を音として「あの感じ」を聞くために、Sightはどのような仕組みなのですか?

鈴木良平さん/専門はUI・音響、音響技術・アプリケーションを担当

鈴木良平さん(以下、鈴木) これまでもソニフィケーション(視覚を音に変える可聴化技術)を使ったデバイスはありました。でも多くは視覚障がい者のためのもので、車を避ける、家族がどこにいるか知る、熱湯に触らないようにするといった個別のタスクに特化していたんです。つまり、まず見つけなきゃいけない、知らなきゃいけない情報ありきで、トップダウン的にそれに特化したレコグナイザーを用意して、対象物が近づいてきたらそれぞれに対応した音を鳴らすといった仕組みです。こういうデバイスは各タスクに対してはよく働きますけど、僕たちがやりたいのは全体的な空間の感じ、特定の物体よりも空間の広がりを知覚することなので、今までのアプローチではうまくいかない。「Sight」はボトムアップなんです。「クルマ」などの情報レベルではなく、「かど」や「エッジ」などの低レベルな情報上手く合わせて全体的な感じを得ています。

「山」という物体ではなく、そのエッジを拾って音にしている様子。日が暮れることで境目がぼやけてくると音も変わる。

鈴木 でも、低レベルな情報をそのまま全部音にすると何がなんだかわからない雑音になってしまいます。識別できる範囲で、(全体的な空間の感じをもたらす)低レベルな情報を耳に与えるにはどうしたらいいのか。このときに人間の視覚がどう網膜から入ってきて脳で処理されているのかを考えました。ピクセルレベルの低レベル情報から、抽象化処理をしてエッジやかどなどの特徴レベルに、網膜から始まってだんだん高位のレベルにボトムアップされていく。

このプロセスとパラレルなのが、コンピュータービジョン(コンピューターによる画像認識、処理などの研究)がやっていることです。入力された画像から特徴量を得て(人間の第一次視覚野で行なわれる。エッジ・かどを識別)、次にその配置から高レベルな情報を探っていく(人間の高次視覚野で行なわれる。運動方向の分類、物体認識)。抽象化していった先にある情報を全部まとめると、最終的に「クルマ」になる。僕たちはその途中のレベルの情報、エッジ・かどの情報の段階であえて音にして、その先の抽象化は脳に任せるんです。そうするとこれまでよりも幅広い情報を得られる可能性があるからです。

鈴木 ひとつひとつのエッジは情報量が多く、128次元もの特徴量を持っています。そのまま音にしても意味がわからない。ただ自然界にあるようなエッジにはある程度、特徴的な成分があります。それらを機械学習を使って、簡単な主成分分析みたいな手法で次元を減らすんです。128次元を6次元に圧縮して音に変換すると、やわらかいソファのようなものと角張ったものでは違った感じの音が生成されるという仕組みです。

「いかようにも人の脳は変わりうる」

ギズ お話を聞いていると、「イルカになる」とか「知覚の仕方を拡張するとか」バイオハック的な試みにも感じられます。目で見るという行為を再定義することにもつながるでしょうか?

伏見 というか、「見る」ってことに目が必要なのかってことかもしれないですね。僕たちはそれを普段は疑ってはいないけど、実は見るという行為は目がなくても実現できるかもしれない。目が普段は見落としていた、実は無視していた情報を耳で捉えなおすことで、もっと大きな構造だとか逆に細かいテクスチャーがわかるようになるとしたら、それはすごく面白い展開だと思います。

ギズ 例えば「Sight」を24時間着けたままで生活するようになったときに、そのことによって人間の脳の機能や知覚のやり方が変わることってあると思いますか。

和家尚希さん/専門は神経科学、画像処理を担当

和家尚希さん(以下、和家) あると思います。そもそも知覚っていうものが何なのか、どう定義されるべきかは難しい問題です。ただ抽象的なことじゃなくて、脳が機能としてどれくらい変わり得るかというと…例えば本当にあった動物実験で、視覚が脳に至る経路と、聴覚が脳に至る経路を繋ぎ変えてしまうもの。子どもの頃にそれをするとどうなるのか。本来ならば聴覚を処理するところに、視覚の情報を処理するような構造ができあがるんです。つまり、脳は新しい情報に柔軟に対応して構造を変化させることができる。

「Sight」が情報の入力の構造を変えることで、それに適応する形で脳の構造が変わるっていうのは十分ありえるかな、と思っています。ただその先でどういった知覚の世界が広がっているのかは、やってみないとわからない。そこは僕ら自身の体で実験しているようなものです(笑)。また「Sight」によって今まで使われてこなかった脳の機能が出てきて、それによって人間の脳が広義的に進化することもあるかもしれない。そういった点で考えてみると、これは脳の機能自体を変えてしまうバイオハックの試みとも言えます。

鈴木 例えばアクロバット飛行をするようなパイロット。僕たちは宙返りすると、すぐにどっちが上かわからなくなるけど、常に飛び回っているような人はそういった環境での定位能力はすごく高くなっているんです。特定のスキルを日頃から行使していると、他の人と違った知覚ができるようになるっていうのはごくごく普通にあることなんです。音が聞こえているとき、今の僕たちは頭の方向を変えても、そんなにセンシティブには音の聞こえ方は変わらない。けどSightを着けているときに頭の方向が90度変われば、まったくサウンドスケープは変わる。Sightをずっと着けて暮らしているうちに、方向による音の聞こえ方の変化にすごくセンシティブになるかもしれない。そういう地味なとこから、知覚の変化が出てくるのではと思っています。

和家 脳の進化というと大げさに聞こえるかもしれませんが、ピアノをやっている人は、指の運動に対する脳の領域が普通の人より広いことがあるんです。いかようにも人の脳は変わりうる。どれくらいすぐ変わるのか、どれくらい強く持続するのかまだわからないけれど、きっと何か変化はあるはずです。

今度こそ人間はイルカになれる?

ギズ 未踏事業の期間を含めた今後の開発でやっていくこと、目指していくゴールはどんなものでしょうか。

鈴木 「音」に関してはまだ手探りです。どうしたら聞き分けられるのか、不快じゃない音にできるのかは試行錯誤しています。ただ、緑いっぱいの田園では軽やかなメロディが聞こえるとか、音楽的なものにしてしまうと乗せられる情報量はかなり小さいしざっくりとしたものになってしまう。今のところは、自然からサンプリングして変換した環境音のようなものがいいなと思っています。ただしこれがベストなのかはまだわからない。音と空間的な特徴をどう対応づけるのかは、これまでもいろんな研究者が苦労してきたところです。

伏見 ソニフィケーション、視覚的な何かを耳で聞こえるようにする技術が流行ったのが15年前くらいだと思います。先行研究は2001、2002年ごろが多い。みんなイルカになりたくてやってみた。でもこれは無理じゃないかと去っていったんです。そこにもう一度僕らが挑んでみる。武器があるとすると、ひとつは画像認識の技術がどんどん発達してきていることです。視覚的な画像から意味を抽出するアルゴリズムが発達してきました。その力を借りて昔の人たちができていなかったことができてくるのではと思っています。

ギズ 最近ギズモード・ジャパンでもとりあげたんですが、画像をアップロードすると人工知能がそれが何かを教えてくれるウェブサイトとか出てきましたよね。

伏見 まさにそういう技術の基礎を借りてこようと思っています。いまはディープラーニングの技術を応用した新しいバージョンに取り組んでいるところです。ディープラーニングのいま使っている一般物体認識のためのネットワークでは、15以上の層にわけてニューロンユニットを配置しています。入力に近い、つまり浅い層では、エッジ検出など単純な処理を学習し、深い層になるほど抽象的なものや景色の特徴を学習できるような仕組みです。「犬」をみたときに「ふわふわ」「目が2つ」「茶色っぽい」など「犬」を判断するための手がかりが、もっとも深い層のユニットに現れているイメージ。そこで学習されている情報を音に変換することで、ディープラーニングやぼくたち人間が物体を認識するために使っている高い抽象度の高い情報を変換しようという試みですね。

鈴木 障がい者支援という文脈ではたくさん高度な技術がそろってきています。例えば指差すとその先が何色になってるかを教えてくれるとか。そういう意味では、実用的なものは作れるレベルになってきている。だから、僕たちはすぐさま実用化というよりはもう少し先を見ています。

ギズ 現在は基礎の開発に取り組むフェーズにあるということですよね。現段階でも「Sight」のテクノロジーの一端を体験することはできますか?

伏見 音響による空間知覚を体験できるようなキットを作って試してもらえたらいいなと。バンドを巻いてそこにiPhoneをさすような形を考えています。「Sight」は、カメラと音を出す装置があれば実現できるんです。スマートフォンのカメラは前方向しか撮れないので、普通の視野よりは狭くなりますけど。今は「簡単に配布・体験できるキット」と「正確に認識できるフラッグシップモデル」の2ラインの開発を同時進行している状況です。

和家 (現時点のプロトタイプでは)目隠しをしているけど、本当に必要かどうかはわからないです。メガネ型にして、見ながら音が聞こえてもいいかもしれないし。今はコンセプトが先行している状態で、「Sight」の最終形態や、どう使われるか、どういった形で、誰が、どんな風に、は決まっていない段階なんです。具体的にどういった応用先があるかは、体験した人が考えていってくれるかもしれないし。それに向けた基礎の開発をやろうとしています。

ギズ ありがとうございました!

***

メンバーからは「すぐに役立つ便利なデバイス」をつくるのではなく、ヒトの感覚拡張にこだわって制作する姿勢が伺えました。

本格的な開発は始まったばかりのSightですが、開催中の東京大学制作展 EXTRA 2015「グッバイ・マイ・ボディ」にて体験することができますよ。

source: Sight(和家尚希、鈴木良平、伏見遼平、宗像悠里)

(斎藤真琴/取材協力:Haruka Mukai)