やっぱり人間が作っているからなんでしょうか。

プログラムは客観的でも、公平でもないかもしれない…そんな悩ましい研究結果が発表されました。仕事への応募や住宅ローンの決定など人々の生活に影響を与えるソフトウェアは、その処理の最中でバイアスがかかってしまうおそれがあるのだそうです。

ある仕事への応募者の履歴書をソフトウェアでより分け、成績評価点や経験年数で点数化する企業のやり方は一般的なものです。関係するスキルや経験、目標をキーワード検索できるなんていうプログラムもあります。理論上、こういったプログラムは適任ではない人を除外するだけでなく、人種や性別などへの偏見を持ち込まないために使われるものです。

このところ、こういったプログラムにどのようにバイアスがかかってしまうのか、議論が重ねられてきています。応募者を選定するプログラムの多くには、コンピューター・サイエンティストが機械学習アルゴリズムと呼ぶ、パターンを発見して理解することに適したアルゴリズムが使われています。例えばアマゾンの機械学習アルゴリズムは、製品をおすすめするために私たちの買い物に関する行動を分析しますし、ネットフリックスが推奨してくる番組なんかも同じ仕組みです。

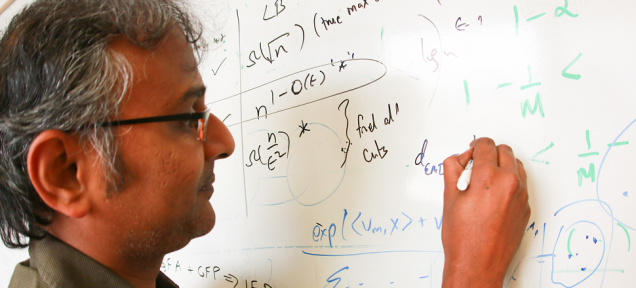

この機械学習を用いた方法について、複数の研究者たちは、履歴書チェックソフトが応募者のデータをひとまとめにし、結果として人間がするような人種やジェンダーによる差別をうっかりマネしてしまうものになるのでは…と不安を寄せています。「人工知能(AI)を人間に近づければ近づけるほど、私たちの持つ偏見や制限も含んだやり方をAIが学んでしまうのは皮肉なことです」-こんな声明を出したのは、ユタ大学のコンピューター・サイエンス研究者のSuresh Venkatasubramanian准教授です。

ユタ大学、アリゾナ大学、ハバフォード大学などが共同で行なった共同研究では、プログラムにバイアスを不意に学ばせ、そしてバイアスのかかった決定が下されないように、データをシャッフルするテストの方法が編み出されました。研究チームはこの研究結果をオーストラリアのシドニーで行なわれたAssociation for Computing Machineryの第21回カンファレンスで発表しました。

研究チームは、機械学習アルゴリズムにバイアスがかかっていないかどうか確かめるために、別の機械学習アルゴリズムを利用しています。この方法は、履歴書チェックソフトが応募者の出身校の名前や住所、そして本人の名前などから、人種やジェンダーを正確に予想できるかどうかをテストするもの。テストの結果、もし予想が当たっていたら、その履歴書チェックソフトが応募者を不当に差別しているというわけです。履歴書チェックソフトが差別をしている場合は、ソフトのデータを調整し、アルゴリズムがバイアスを引き起こしているデータを見られないようにすることが解決策になるのだそうです。

人間らしくすればするほど完璧ではなくなってしまうかもしれないAIの問題。難しいです。

top image: Vincent Horiuchi via University of Utah

source: University of Utah

Kiona Smith-Strickland - Gizmodo US[原文]

(conejo)

- 世界でもっとも強力な9のアルゴリズム

- ジョン マコーミック|日経BP社

- 人工知能は人間を超えるか (角川EPUB選書)

- 松尾 豊|KADOKAWA / 中経出版